课程介绍:

您已经知道如何用 Python 构建人工神经网络,并且您有一个可用于 TensorFlow 的即插即用脚本。神经网络是机器学习的主要内容之一,它们始终是 Kaggle 比赛中的顶级竞争者。如果您想提高神经网络和深度学习的技能,这门课程适合您。

您已经了解了反向传播,但还有很多未解答的问题。如何修改它以提高训练速度?在本课程中,您将学习批量和随机梯度下降,这两种常用技术可让您在每次迭代时仅使用少量数据样本进行训练,从而大大加快训练时间。

您还将了解动量,这可以帮助您通过局部最小值并防止您对学习率过于保守。您还将了解自适应学习率技术,如 AdaGrad、RMSprop 和 Adam,它们也有助于加快您的训练速度。

因为您已经了解神经网络的基础知识,所以我们将讨论更现代的技术,例如 dropout 正则化和批量标准化,我们将在 TensorFlow 和 Theano 中实现这些技术。课程不断更新,更先进的正则化技术将在不久的将来推出。

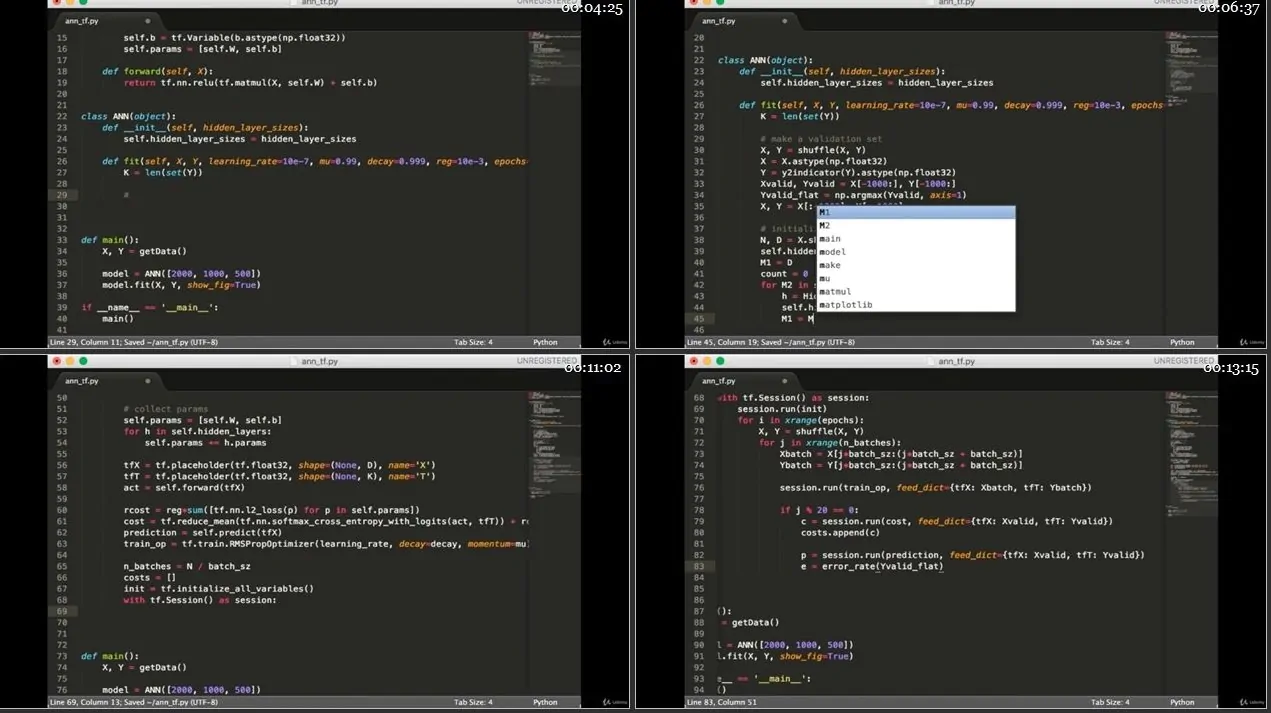

在我的上一门课程中,我只是想让你先睹为快 TensorFlow。在本课程中,我们将从基础开始,以便您准确了解正在发生的事情 – 什么是 TensorFlow 变量和表达式,以及如何使用这些构建块来创建神经网络?我们还将研究一个存在时间更长并且非常受深度学习欢迎的库 – Theano。使用这个库,我们还将检查基本构建块——变量、表达式和函数——以便您可以自信地在 Theano 中构建神经网络。

Theano 是当今所有现代深度学习库的前身。今天,我们几乎有太多的选择。Keras、PyTorch、CNTK(微软)、MXNet(亚马逊/Apache)等。在本课程中,我们涵盖了所有这些!挑选你最喜欢的那个。

因为 TensorFlow 和 Theano 的主要优势之一是能够使用 GPU 来加速训练,所以我将向您展示如何在 AWS 上设置 GPU 实例并比较 CPU 与 GPU 的速度以训练深度神经网络.

凭借所有这些额外的速度,我们将查看一个真实的数据集——著名的 MNIST 数据集(手写数字图像),并与各种基准进行比较。这是研究人员在提出问题“这件事行得通吗?”时首先看到的数据集。

这些图像是深度学习历史的重要组成部分,至今仍用于测试。每个深度学习专家都应该非常了解他们。

本课程侧重于“如何构建和理解”,而不仅仅是“如何使用”。阅读一些文档后,任何人都可以在 15 分钟内学会使用 API。这不是关于“记住事实”,而是关于通过实验“亲眼看到”。它将教您如何可视化模型内部发生的事情。如果您想要的不仅仅是对机器学习模型的肤浅了解,那么本课程适合您。

我的课程是您将学习如何从头开始实施机器学习算法的唯一课程

其他课程会教你如何将数据插入到库中,但你真的需要 3 行代码的帮助吗?

在用 10 个数据集做同样的事情后,你意识到你没有学到 10 件事。你学到了 1 件事,只是将同样的 3 行代码重复了 10 次……

Genre: eLearning | MP4 | Video: h264, 1280×720 | Audio: AAC, 44.1 KHz

Language: English | Size: 3.71 GB | Duration: 11h 15m

建议的先决条件:

了解梯度下降

概率与统计

Python 编码:if/else、循环、列表、字典、集合

Numpy 编码:矩阵和向量运算,加载 CSV 文件

知道如何使用 Numpy 编写神经网络

您将学到什么

将动量应用于反向传播以训练神经网络

将自适应学习率程序(如 AdaGrad、RMSprop 和 Adam)应用于反向传播以训练神经网络

了解 Theano 的基本构建块 在 Theano 中

构建神经网络

了解TensorFlow

在 TensorFlow 中构建神经网络 构建在 MNIST 数据集上表现良好的神经网络

理解完全梯度下降、批量梯度下降和随机梯度下降之间的区别

理解并实现 Theano 和 TensorFlow 中的 dropout 正则化

理解并实现 Theano 中的批量归一化和 Tensorflow

使用Keras写一个神经网络

使用PyTorch写的神经网络

使用CNTK写的神经网络

编写使用MXNet神经网络

本课程面向的对象:

想要加深机器学习知识的学生和专业人士 想要

更多地了解深度学习的

数据科学家 已经了解反向传播和梯度下降并希望通过随机批量训练、动量和自适应学习率程序,如 RMSprop

那些还不了解反向传播或 softmax 的人应该先学习我之前的课程,Python 中的深度学习